linux

Analizzare il carico dei processi con Munin

Munin, come ho scritto ieri, è uno strumento di monitoring molto potente e flessibile ed esistono centinaia di plugin per gestirne il comportamento.

Dopo aver cercato un po’ mi sono accorto che non esiste un plugin che può monitorare il carico dei singoli processi in esecuzione su una macchina. Alcuni plugin permettono di creare un grafico specifico per un determinato processo ma nessuno lo fa in maniera aggregata per tutti i processi contemporaneamente.

Così, vista la semplicità con cui è possibile scrivere un plugin munin, ho deciso di crearne uno che facesse al caso mio.

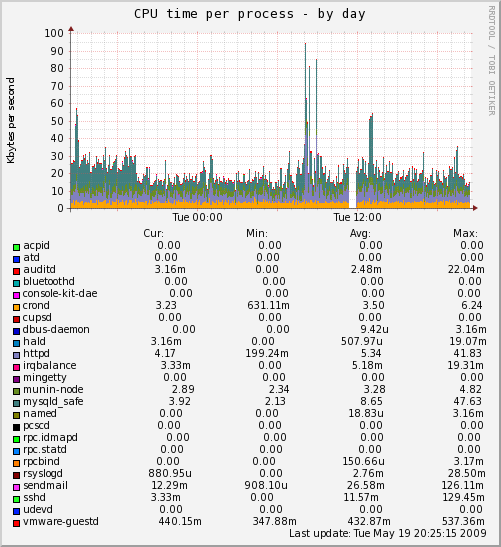

Questo è il risultato che ho ottenuto con poco sforzo:

Oltre al carico di CPU ho deciso di monitorare anche i minor-faults e i major-faults. I minor faults avvengono ogni qual volta un processo cerca di scrivere in una pagina di memoria protetta da scrittura, mentre i major faults avvengono quando questa operazione richiede anche una o più operazioni di I/O (e.g: swap). L’analisi dei minor/major faults può essere utile durante l’indagine di un problema di performance di un sistema.

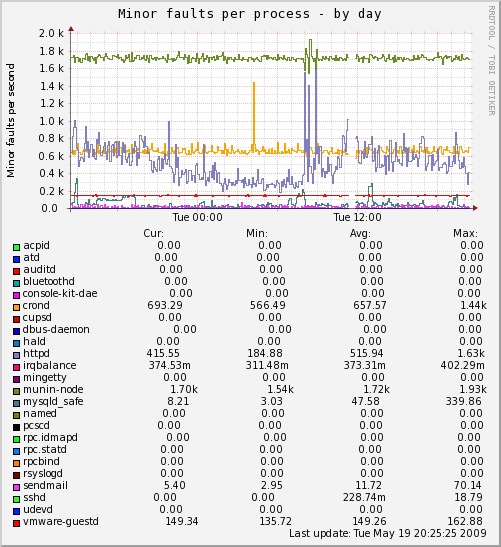

Questo, ad esempio, è il grafico dei minor-faults corrispondente al precendete grafico di carico CPU per la stessa macchina:

I plugin, da copiare nella cartella /etc/munin/plugins sono questi:

– processes_cpu

– processes_minorfaults

– processes_majorfaults

Dopo aver copiato i plugin, è necessario riavviare il munin-node:

sh# service munin-node restart

Possibili migliorie

Purtroppo i colori devo necessariamente lasciarli gestire a munin automaticamente.

Non ho idea di come si potrebbe fare a mettere in legenda solo quei processi che hanno usato almeno un 1% della CPU o funzionalità del genere.

Se lo stesso plugin viene installato in più macchine i processi vengono colorati diversamente per ogni macchina, rendendo di fatto poco intuitivo il confronto. Forse decidere il colore in base ad un hash calcolato dal nome del processo permettere stabilità ma potrebbe capitare che i processi più importanti abbiano poi un colore identico e siano indistinguibili.

Analizzare il traffico dei VirtualHost di Apache con Munin

Prerequisiti

Prerequisiti

Questo articolo prevede l’uso di Fedora Core 10 con Apache 2 installato e funzionante. Altre distribuzioni potrebbero richiedere la compilazione dei pacchetti che invece su FC10 sono già disponibili.

Installare CBand

Fortunatamente anche per il modulo cband esiste un pacchetto precompilato per FC10 e quindi l’installazione è molto rapida:

sh# yum install mod_cband

Installato il mod_cband aggiungiamo alla definizione di ogni VirtualHost che vogliamo monitorare la configurazione di cband:

<IfModule mod_cband.c> CBandLimit 600G CBandExceededURL http://www.google.com CBandScoreboard /var/run/httpd/cband_scoreboard-#DOMINIO# CBandPeriod 1W </IfModule>

Da notare che ho impostato un limite di 600GB in 1 settimana, che nel mio caso corrisponde praticamente a non limitare, poichè il traffico è molto minore. E’ però necessario imporre un limite (seppur irraggiungibile) per far si che cband conteggi l’utilizzo di banda.

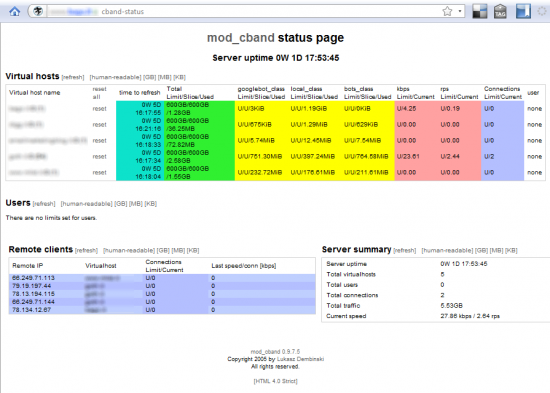

Fatto questo per ogni VH possiamo testare che la configurazione sia corretta, riavviare apache e vedere la pagina delle statistiche di cband:

sh# httpd -t sh# service httpd restart

Aprendo http://localhost/cband-status vedremo una pagina simile a questa:

Impostare Classi in Cband

cband permette di definire fino a 3 classi di utenti in base all’IP. Con un po’ di lavoro possiamo quindi identificare i bot dei motori di ricerca, magari tenendo separato google che ci interessa più degli altri, e le classi di IP locali, per evitare che alcune macchine che effettuano richieste automatizzate possano inficiare le statistiche.

Queste sono le mie configurazioni messe in /etc/httpd/conf.d/mod_cband.conf

<CBandClass googlebot_class> CBandClassDst 66.249.64/20 </CBandClass> <CBandClass local_class> CBandClassDst XXX.XXX.XXX.XXX CBandClassDst 127.0.0.1 </CBandClass> <CBandClass bots_class> # Yanga CBandClassDst 91.205.124.3/22 # Exabot CBandClassDst 193.47.80.0/24 # Slurp CBandClassDst 72.30.0.0/16 CBandClassDst 74.6.0.0/16 CBandClassDst 67.195.114.0/24 CBandClassDst 67.195.37.0/24 CBandClassDst 202.160.178.0/20 # Yandex CBandClassDst 77.88.22.0/21 CBandClassDst 93.158.146.0/23 # Jyxobot CBandClassDst 195.113.214.197 # DotBot CBandClassDst 208.115.111.0/24 # libwww-perl CBandClassDst 195.210.89.0/24 # MSN con referrer di ricerca # CBandClassDst 65.55.104.0/21 # Twiceler CBandClassDst 216.129.119.1/24 CBandClassDst 64.1.215.1/24 CBandClassDst 208.36.144.1/24 CBandClassDst 38.99.13.1/24 CBandClassDst 38.99.44.1/24 # AskJeeves CBandClassDst 66.235.124.0/24 # majestic12 CBandClassDst 85.23.64.207 CBandClassDst 212.50.134.32 CBandClassDst 85.16.151.236 CBandClassDst 85.113.244.201 CBandClassDst 68.192.9.221 CBandClassDst 85.178.109.63 # Wikio Feed CBandClassDst 84.55.184.91 # Turnitin CBandClassDst 65.98.224.7 # MSN # CBandClassDst 65.55.208.0/24 # CBandClassDst 65.55.51.0/24 CBandClassDst 65.55.0.0/16 CBandClassDst 219.142.53.0/24 # Gaisbot CBandClassDst 122.147.76.64/28 CBandClassDst 210.66.69.128/26 CBandClassDst 219.87.182.128/27 CBandClassDst 220.228.152.64/27 </CBandClass>

In questo modo il calcolo del traffico avverrà separatamente per “classe”. Potremo conoscere il traffico degli “utenti normali” per differenza, sottraendo dal traffico totale le classi local_class, bots_class, googlebot_class.

Installare Munin

Munin è uno strumento di monitoring con un meccanismo di estendibilità a plugin estremamente semplice ed intuitivo (rispetto a MRTG) che permette di monitorare uno o più server.

Munin si divide infatti in due pacchetti: munin e munin-node.

Mentre munin-node è necessario in ogni server che intendiamo controllare il pacchetto munin serve solamente nella macchina che aggregherà le statistiche per creare dei grafici tramite il noto strumento rrdtool.

Su Fedora Core 10 installare munin è molto semplice:

sh# yum install munin munin-node

Una delle peculiarità di munin è l’autoconfigurazione: i plugin infatti possono verificare l’ambiente in cui sono installati per stabilire se sono “applicabili” all’ambiente o meno. Per verificare l’autoconfigurazione possiamo lanciare questo comando:

sh# munin-node-configure --shell

L’output di questo comando conterrà l’elenco dei comandi da impartire alla shell per installare i plugin che dichiarano la loro compatibilità.

Creare un plugin munin per mod_cband

A questo punto non ci resta che creare un plugin munin che legga la pagina /cband-status e permetta così a munin di visualizzare il grafico degli accessi diviso per vhost.

Questo è un esempio del plugin munin che richiede la pagina e ne estrae i dati:

#!/bin/sh

URL="http://localhost/cband-status?refresh=15&unit=K";

WGET=`which wget`;

WGET_FLAGS="-Yoff";

# Settigs required for autoconf

#%# family=manual

#%# capabilities=autoconf

if [ "$1" = "autoconf" ]; then

echo no

exit 0

fi

if [ "$1" = "config" ]; then

echo 'graph_title CBandwith Usage '

echo 'graph_args -l 0'

echo 'graph_category apache'

echo 'graph_info This graph shows per virtual host traffic from the cband module.'

echo 'graph_vlabel Kbytes per ${graph_period}'

wget -q $WGET_FLAGS "$URL" -O - | grep -A 3 http |grep "^<td .*http" |sed -e 's^.*http://\(.*\)".*^\1^' | while read site; do

metricname=$(echo $site | sed -e 's/\.//g')

#echo $metricname $site

echo $metricname'.label '$site

echo $metricname'.info Traffic generated on '$site'.'

echo $metricname'.min 0'

echo $metricname'.type DERIVE'

done;

exit 0

fi

if [ -x $WGET ]; then

SITES=$(wget -q $WGET_FLAGS "$URL" -O - | grep -A 3 http |grep "^<td.*http" |sed -e 's^.*http://\(.*\)".*^\1^')

$WGET -q $WGET_FLAGS "$URL" -O - | grep -A 3 http |grep "^<td.*\(color\|http\)" | while read v; do

echo -n $v | sed -e 's^.*http://\(.*\)".*^\1^' | sed -e 's/\.//g'

echo -n '.value '

read v;

echo $v | sed -e 's^.*\/\(.*\)KB.*^\1^'

done;

exit 0

fi

exit 0

E questo è il risultato:

I plugin munin che ho creato sono molto spartani ma utili e controllano il traffico totale, quello di google, quello degli altri bots, e il traffico utente (il totale meno i robot e meno la classe locale).

Conclusioni

Il modulo cband, nonostante non più aggiornato dal 2006, non sembra pesare sulle performance e la stabilità di apache2 e dopo un mesetto di utilizzo ne sono soddisfatto.

Dovrei migliorare il plugin configurando meglio le impostazioni dei grafici (usare il min/max/avg, stili di linea differenti.

Troubleshooting

Se cband non vi funziona bene probabilmente si tratta di un problema di ordine di caricamento dei files nella /etc/httpd/conf.d . Questi files vengono caricati in ordine alfabetico, quindi se le definizioni dei virtualhost le avete qui assicuratevi che vengano il ordine alfabetico dopo al mod_cband.conf

Io, per convenzione, li chiamo vh-dominio.conf

Trasloco di siti, propagazione DNS e Reverse Proxy

Lo spostamento di un sito/servizio web da un IP ad un altro può essere molto problematica. I grattacapi principali sono dovuti al tempo di propagazione del DNS, durante il quale i visitatori potrebbero approdare sia sul vecchio che sul nuovo IP in funzione di quale server DNS utilizzano e lo stato della cache.

Per ridurre al minimo questo problema è buona norma ridurre l’expire della cache di un dominio prima di un’operazione di trasloco di questo tipo, ma questa soluzione riduce solo il problema senza rimuoverlo.

Il problema fondamentale consiste nel fatto che a volte non possiamo permetterci che i due servizi su i 2 IP diversi ricevano richieste contemporaneamente perchè queste richieste potrebbero modificare lo stato di entrambi i server creando una divergenza non più sincronizzabile. Basta pensare ad un blog ed il fatto che alcuni utenti potrebbero commentare sul primo IP mentre altri sul secondo, con la conseguente perdita di dati che si avrebbe a transizione completata.

Una soluzione spesso adottata è quella di far rispondere il nuovo (www.dominio.com) sito ad una nuova URL tipo nuovo.dominio.com, sincronizzare il database, modificare la configurazione del webserver per far si che qualunque richiesta a www.dominio.com venga rediretta (302, temporary redirect) a nuovo.dominio.com e poi aggiornare il DNS. Questa soluzione però, oltre a non essere completamente trasparente per l’utente finale, potrebbe creare problemi nel caso in cui l’applicazione che dobbiamo spostare non sia indipendente dal nome. Potremmo infatti avere già dei cookie impostati per quel detterminato l’hostname o potremmo avere dei punti del codice che controllano quale sia l’hostname attuale.

Per questo motivo la mia soluzione preferita è quella di utilizzare un reverse proxy. In pratica si configura il sito nuovo, si sincronizza il db, poi si configura il vecchio non più per fare un redirect ma piuttosto per andare a chiedere la stessa pagina al sito nuovo e fornirla al navigatore.

Per fare questo con apache2 è sufficiente abilitare il mod_proxy in /etc/httpd/conf/httpd.conf togliendo il # dalle due righe:

LoadModule proxy_module modules/mod_proxy.so LoadModule proxy_http_module modules/mod_proxy_http.so

ed aggiungere al virtualhost che stiamo spostando le seguenti istruzioni:

ProxyRequests Off ProxyPreserveHost On ProxyPass / http://[IP-NUOVO-SERVER]/

Con questa configurazione facciamo sì che le richieste fatte a quel sito vengano gestite non più dal server locale, ma piuttosto apache2 si preoccuperà di andarle a fare sull'[IP-NUOVO-SERVER]. ProxyPreserverHost ci serve così da poter mantenere l’Host nella richiesta e fare in modo che il server di destinazione riceva la richiesta come se l’avesse ricevuta dall’utente originale.

ProxyPass dice che tutte le pagine vengono “girate” al nuovo IP, ma potremmo anche decidere di fare questa operazione solo con alcune sottodirectory.

Esiste però ancora un problema legato a questa tecnica, e cioè che il nuovo server vedrà tutte le richieste venire dall’IP del vecchio server e non conoscerà più l’IP originale. Questo significa che i log avranno l’IP del “proxy” e che alcuni script potrebbero non funzionare bene.

Per questo viene d’aiuto un altro modulo apache chiamato mod_extract_forwarded che permette di estrarre l’IP presente nell’header X-Forwarded-For (aggiunto dal mod_proxy) e sostituirlo al remote address usato da apache.

Se il vostro nuovo server è una fedora core 10, come la mia, allora potete installare il modulo direttamente:

shell# yum install mod_extract_forwarded.i386

Il file di configurazione del modulo è in /etc/httpd/conf.d/mod_extract_forwarded.conf . E’ sufficiente aprirlo e modificare la riga MEFaccept inserendo l’elenco degli IP dei “proxy” fidati:

MEFaccept [IP-VECCHIO-SERVER]

E’ importante specificare questa opzione solo per gli IP dei proxy fidati perchè l’header X-Forwarded-For è un semplice header HTTP e di conseguenza è falsificabile molto semplicemente. Basti pensare che esiste una estensione Firefox che permette di impostare tale header a piacimento.

Ecco fatto, sia i log che tutte le applicazioni mostreranno l’IP originale e non quello del “proxy”.

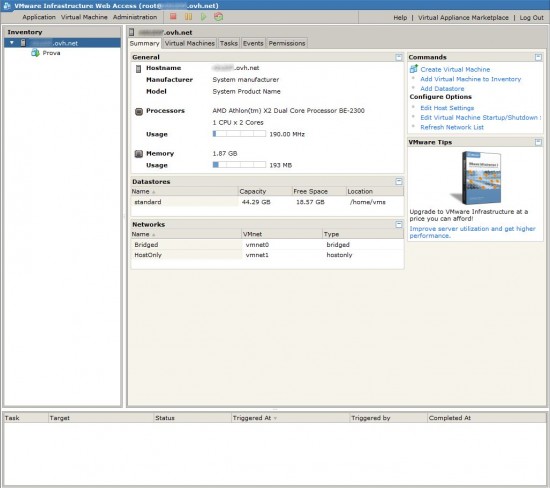

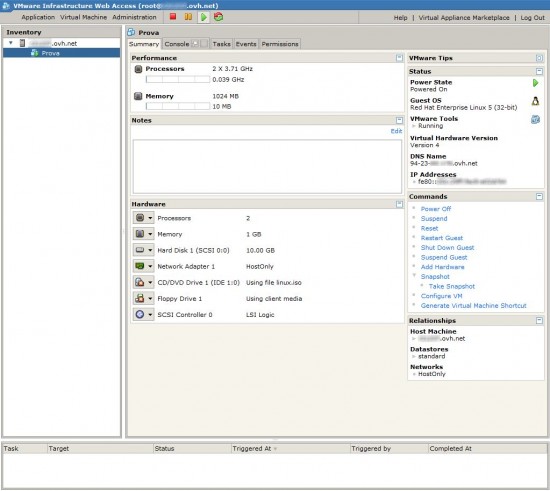

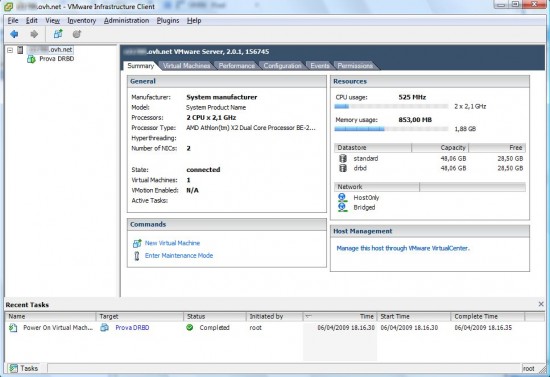

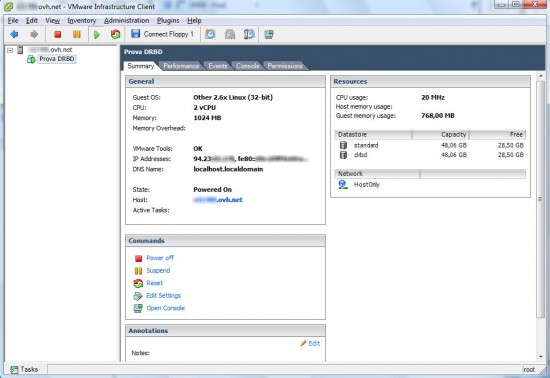

Liberare 240MB di RAM disabilitando la console web di VMware Server 2

La versione 2.0 di VMware Server ha introdotto una nuova interfaccia di gestione via web. Si tratta di una interfaccia molto comoda ed esteticamente molto gradevole che però utilizza, nell’installazione predefinita, 240MB di RAM.

La cosa interessante è che i servizi di gestione remota sono un servizio separato e quindi con Virtual Infrastructure Client 2.5 è possibile connettersi alla porta 8333 (in https) del server sul quale è installato VMware Server 2 e gestire tutti i parametri.

L’unica limitazione è che con il VIC è possibile gestire solamente i formati di macchina virtuale fino al 4 mentre quelli fatti con l’interfaccia web (webAccess) sono in versione 7. Se volete mantenere la possibilità di disabilitare il webAccess, quindi, vi consiglio di creare le vostre macchine virtuali con il VI client.

Veniamo ora alla modifica del file /etc/rc.d/init.d/vmware

Dovrete trovare la funzione:

vmware_start_webAccess() {

echo -n ' '"$webAccessServiceName"

$watchdog -s webAccess -u 30 -q 5 "$webAccess $webAccessOpts start" > /dev/null 2>&1 &

}

e modificarla in

vmware_start_webAccess() {

echo -n ' '"$webAccessServiceName"' DISABLED'

# echo -n ' '"$webAccessServiceName"

# $watchdog -s webAccess -u 30 -q 5 "$webAccess $webAccessOpts start" > /dev/null 2>&1 &

}

In questo modo al prossimo riavvio di vmware verrà comunque lanciato hostd (il servizio di gestione base) ma non il webAccess (l’applicativo basato su Java/Tomcat che si frega così tanta RAM).

Non si capisce perchè VMware abbia deciso di spezzare in script di avvio separati altri 3 servizi ma poi abbia deciso di consolidare hostd (management per le virtual machine) con webAccess (accesso web al management).

Chrissy propone una soluzione alternativa allo stesso problema.

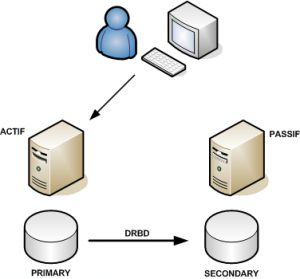

Installare DRBD su un RPS di OVH e Fedora

Premessa

DRBD (Distributed Replicated Block Device) è una sorta di disco virtuale che gestice un RAID 1 via rete. In pratica due dischi installati su due macchine fisiche diverse possono essere visti come unico disco. DRBD è uno dei mattoni fondamentali per la gestione di un cluster HA (High Availability) low cost.

Requisiti

Esistono gli RPM di DRBD già fatti per Centos e si possono usare anche con la Fedora, però funzionano solo con i kernel ufficiali delle rispettive distribuzioni, quindi dovremo crearci il nostro pacchetto.

Innanzitutto dovete assicurarvi di avere installato un kernel che supporta i moduli e che supporta la funzionalità “Connector”.

Inoltre è consigliabile che abbiate riservato una partizione, identica sulle due macchine che vorrete mantenere sincronizzate, da utilizzare con DRBD.

Se non ne avete una potrete comunque provare creando un loop device (questo crea un loop device da 10GB):

shell# dd if=/dev/zero of=/home/drbdloop bs=1024 count=10485760 shell# losetup /dev/loop0 /home/drbdloop

In questo modo avrete un device (/dev/loop0) da utilizzare come disco per DRBD.

Compilazione di DRBD

shell# cd /usr/src shell# wget http://oss.linbit.com/drbd/8.3/drbd-8.3.1.tar.gz shell# tar -zxf drbd-8.3.1.tar.gz shell# cd drbd-8.3.1 shell# make rpm

Nel mio caso mi è stato dato un errore perchè nel mio sistema mancava flex.

errore: Compilazione dipendenze fallita:

flex necessita di drbd-8.3.1-3.i386

In realtà l’errore italiano è tradotto male. Il problema è l’esatto opposto. E’ sufficiente installare flex e ripetere il make:

shell# yum install flex Installato: flex.i386 0:2.5.35-2.fc9 shell# make rpm [ COMPILAZIONE ] + exit 0 You have now: -rw-r--r-- 1 root root 185530 3 apr 11:23 dist/RPMS/i386/drbd-8.3.1-3.i386.rpm -rw-r--r-- 1 root root 304874 3 apr 11:23 dist/RPMS/i386/drbd-debuginfo-8.3.1-3.i386.rpm -rw-r--r-- 1 root root 154010 3 apr 11:23 dist/RPMS/i386/drbd-km-2.6.28.4_custom_std_ipv4_32_mod-8.3.1-3.i386.rpm

A questo punto sarà sufficiente installare drbd (i tools) e drbd-km (il modulo del kernel).

Installazione di DRBD

shell# rpm -Uvh --force dist/RPMS/i386/drbd-8.3.1-3.i386.rpm dist/RPMS/i386/drbd-km-2.6.28.4_custom_std_ipv4_32_mod-8.3.1-3.i386.rpm

errore: Dipendenze fallite:

kernel necessita di drbd-km-2.6.28.4_custom_std_ipv4_32_mod-8.3.1-3.i386

La distribuzione di fedora core 9 fatta da OVH non include un pacchetto kernel, ma noi abbiamo installato il kernel manualmente e quindi forziamo l’installazione.

shell# rpm -Uvh --nodeps dist/RPMS/i386/drbd-8.3.1-3.i386.rpm dist/RPMS/i386/drbd-km-2.6.28.4_custom_std_ipv4_32_mod-8.3.1-3.i386.rpm Preparazione in corso... ########################################### [100%] 1:drbd ########################################### [ 50%] 2:drbd-km-2.6.28.4_custom########################################### [100%] shell#

Ogni volta che cambierete il kernel dovrete ripetere questa procedura ed installare il nuovo modulo del kernel (ne possono coesistere più di uno).

Configurazione DRBD

D’ora in poi ipotizzerò che le due macchine siano rXXXX1.ovh.net e rXXXX2.ovh.net, che l’IP delle due macchine sia rispettivamente 87.98.XXX.101 e 87.98.XXX.102 e che per entrambe le macchine la partizione di cui tenere il mirror sia /dev/sda5.

Innanzitutto dovremo configurare la risorsa (che chiamo “r0” ma alla quale potrete assegnare il nome che preferite) su /etc/mrtg.conf

resource r0 {

protocol C;

startup { degr-wfc-timeout 120; }

syncer { rate 3M; al-extents 257; }

on rXXXX1.ovh.net {

device /dev/drbd0;

disk /dev/sda5;

address 87.98.XXX.101:7789;

meta-disk internal;

}

on rXXXX2.ovh.net {

device /dev/drbd0;

disk /dev/sda5;

address 87.98.XXX.102:7789;

meta-disk internal;

}

}

Una volta configurato possiamo preparare il disco con i metadati di DRBD ed attivare la risorsa:

shell# drbdadm create-md r0 shell# drbdadm up r0

Fate la stessa cosa sul secondo server e poi, sul server che volete sia il primario (quello che potrà montare la partizione) fate:

shell# drbdadm -- -o primary r0

Ora /dev/drbd0 è un dispositivo a blocchi (disco virtuale) valido e possiamo procedere nella formattazione:

shell# mkfs.ext3 /dev/drbd0

A questo punto potrete montare il disco ed utilizzarlo

shell# mkdir /mnt/discoha shell# mount /dev/drbd0 /mnt/discoha

Se non volete rischiare di perdere tutti i dati per un comando errato è d’obbligo la lettura del manuale, per una buona comprensione dello stato di connessione, dello stato dei dischi e dello stato della sincronizzazione.

Se vi interessano configurazioni master-master in cui entrambi gli host possono usare contemporaneamente il disco allora avrete bisogno di una filesystem distribuita come OCFS2 o GFS: leggete l’articolo di GuiGui che riporto in fondo all’articolo per un esempio.

Riferimenti

Dal manuale – Building a DRBD RPM package

Articolo di GuiGui –

Mise en oeuvre d’un système de fichier distribué et accès concurrents en SAN avec DRBD, ISCSI ,OCFS2 et DM-Multipath

Pagine

Articoli recenti

Archivi

- Luglio 2009 (1)

- Giugno 2009 (3)

- Maggio 2009 (2)

- Aprile 2009 (8)

- Marzo 2009 (1)